Tekoälyyn liittyy muitakin uhkakuvia kuin maailmanvalloitus

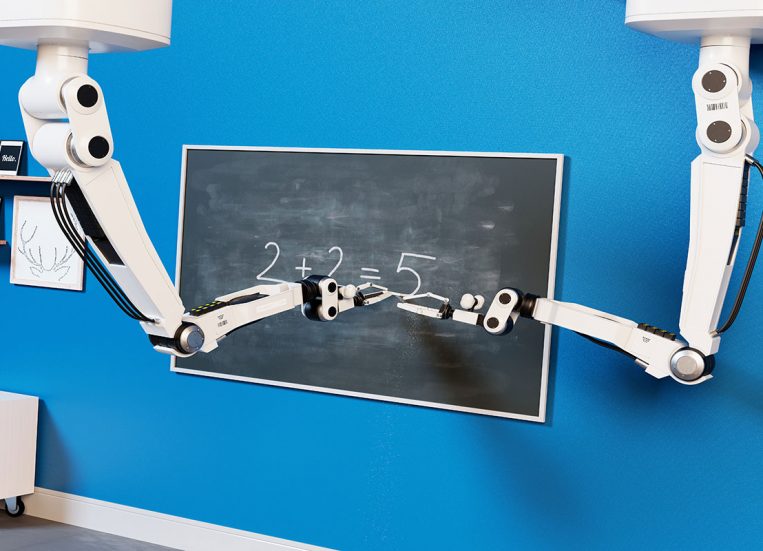

30.09.2024Klassinen tekoälyyn liittyvä uhkakuva on se, että järjestelmät kehittyvät niin älykkäiksi, että koneet ottavat vallan. Entä jos tekoäly ei olekaan tarpeeksi älykäs? Mitä jos se antaa vakuuttavia vastauksia, jotka perustuvat rajattuun tai väärään tietoon? Mitä jos hyvä idea jää ajatuksen tasolle?

Tekoälyyn liittyvä kehitys on nopeaa ja siihen liittyvistä hyödyistä puhutaan paljon. Kuten kaikessa, myös tekoälyssä piilee omat riskinsä. Tähän artikkeliin on kasattu niistä muutamia.

Datan laatu ja monipuolisuus

Tekoäly perustaa ratkaisunsa dataan, jolla se on koulutettu. Jos koulutuksessa käytetty data on virheellistä, virheitä tulee myös tekoälyn tuottamiin ratkaisuihin. Hyvänlaatuista dataa tulee olla myös määrällisesti paljon.

Datan tulee olla monipuolista, sillä liian yksipuolinen data voi johtaa vinoumiin. Jos tekoälyratkaisun tarkoituksena on esimerkiksi auttaa jonkin tietyn sairauden diagnosoimisessa, mutta sen koulutukseen on käytetty vain aikuisista saatua dataa, kyseinen sairaus voi jäädä diagnosoimatta lapsipotilaalta, mikäli sairaus tyypillisesti oireilee lapsilla eri tavalla.

Testaamisen vähyys tai yksipuolisuus

Jotta ongelmat huomataan ajoissa, on kattava testaaminen välttämätöntä. Testaamista tulee tehdä tarpeeksi monta kertaa ja erilaisissa ympäristöissä. Liian vähäinen testaaminen voi johtaa esimerkiksi siihen, ettei järjestelmä toimi odotetusti, kun se siirretään kehitysympäristöstä oikeaan käyttöön.

Yksityisyys

Tekoälyratkaisuja käytettäessä on tärkeää huomioida, mitä tietoja järjestelmään voi syöttää. Vaarana on, että tiedot tallentuvat järjestelmään. Käyttäjän on hyvä tietää, mihin hänen syöttämiään tietoja käytetään ja miten niitä käsitellään.

Riittämätön koulutus ja ymmärrys

Työntekijöillä ei tarvitse olla syvällistä ymmärrystä tekoälyn algoritmien toiminnasta, mutta heidän on hyvä tietää pääpiirteittäin, miten se toimii ja mihin se perustaa ratkaisunsa. Jos näin ei tehdä, siitä voi seurata esimerkiksi seuraavat kaksi ongelmaa.

Ensimmäisessä skenaariossa ymmärryksen puute voi aiheuttaa epäluuloa, mikä puolestaan johtaa siihen, ettei tekoälyratkaisuun luoteta eikä sen potentiaalia hyödynnetä.

Toisaalta liiallinen luottamus ei myöskään ole hyvästä. Jos ajatellaan, että tekoäly on huippuälykäs, eikä esimerkiksi tiedetä, että vastaukset perustuvat koulutusdataan, ei niihin välttämättä suhtauduta tarpeeksi kriittisesti.

Varovaisuus

Vaikka tekoälyn hyödyntämisessä piilee riskejä, toisaalta myös tekoälyratkaisujen liian hidas käyttöönotto voidaan nähdä uhkana. Tiukat lain tulkinnat ja varovaisuus saattavat johtaa siihen, ettei hyödyllisiä järjestelmiä oteta käyttöön ollenkaan tai ne otetaan käyttöön reilusti myöhemmin kuin muualla.

Tämä voi vaikuttaa negatiivisesti uusien innovaatioiden syntymiseen ja menestymiseen. Ratkaisut voivat olla joko kiellettyjä tai ne voidaan sallia vasta myöhemmin, kun jossain muualla kehitys on mahdollisesti jo pidemmällä. Tällöin kilpailu esimerkiksi kansainvälisillä markkinoilla voi olla hankalaa.

Tekoälyratkaisujen käyttöönottoon liittyy paljon niin lainsäädännöllisiä kuin eettisiäkin kysymyksiä, eikä niihin kaikkiin ole olemassa vastauksia. Osittain tähän vaikuttaa tekoälyn nopea kehitys ja lainsäädäntöprosessien hitaus. Osittain puolestaan se, että joissain tilanteissa voi olla haastavaa löytää ne säännöt, jotka suojaavat meitä menemättä kuitenkaan liian tiukoiksi.

Otetaan esimerkkinä sairauksien diagnosointiin liittyvät tekoälyratkaisut. Kun puhutaan ihmisten terveydestä ja terveystiedoista, on varovaisuus suotavaa. Toisaalta tekoälyratkaisut voivat auttaa diagnosoinnissa ja nopeuttaa tarvittavan hoidon aloittamista, mikä puolestaan voi parantaa potilaan tulevaisuudennäkymiä.

Lopuksi

Vaikka tekoälyratkaisut kehittyvät nopeaa vauhtia, myös niihin liittyviin käytäntöihin ja sääntelyyn kiinnitetään huomiota. Se näkyy isossa mittakaavassa esimerkiksi Euroopan unionin tekoälysäädöksen muodossa.

Aihetta mietitään myös kansallisella tasolla sekä eri yrityksissä ja yhteisöissä. Xamk on mukana esimerkiksi sosiaali- ja terveysministeriön johtamassa SOTE-tekoälyn ekosysteemissä, joka keskittyy tekoälyn turvalliseen hyödyntämiseen liittyviin kysymyksiin erityisesti sote-alalla.

CyberCare Kymi on Kaakkois-Suomen ammattikorkeakoulun toteuttama hanke, jota rahoitetaan Kymenlaakson liiton kautta Euroopan unionin Oikeudenmukaisen siirtymän rahastosta (JTF). Hanke toteutetaan ajalla 1.11.2023–31.12.2025.